Com a digitalização avançando em praticamente todos os setores, a Inteligência Artificial deixou de ser tendência para se tornar parte ativa de diversos contextos. E, conforme esses sistemas influenciam decisões reais, cresce também a necessidade de entender como operam, quais critérios utilizam e quais efeitos podem gerar.

É nesse ponto que surge a IA Explicável (XAI), uma abordagem voltada a tornar o funcionamento dos algoritmos mais claro, permitindo acompanhar como chegaram a determinada conclusão e possibilitando a verificação das decisões.

Esse movimento ganha ainda mais força quando olhamos para o mercado: segundo a “Research and Markets”, o setor de IA Explicável deve alcançar US$ 20,74 bilhões até 2029, crescendo a uma taxa anual composta de 20,7%. Mas como essa explicabilidade é alcançada na prática? E por que essa transparência importa tanto?

Neste artigo, apresentaremos um guia completo sobre XAI: explicaremos seu conceito, o contexto que levou ao surgimento dessa necessidade, como a abordagem funciona e como ela ajuda a transformar decisões automatizadas em processos mais claros e confiáveis. Acompanhe!

O que é IA explicável?

A Inteligência Artificial Explicável (Explainable Artificial Intelligence, ou XAI) é um conjunto de processos e métodos que mostram de forma clara e confiável como um sistema chega a suas decisões ou previsões.

Enquanto muitos modelos tradicionais funcionam como uma “caixa-preta”, mostrando apenas o resultado final, a XAI busca tornar transparente todo o caminho que levou à decisão — permitindo compreender melhor e confiar mais nos resultados gerados pelos algoritmos de aprendizado de máquina (Machine Learning).

O que significa “explicável” no contexto de IA?

Uma IA é chamada de “explicável” quando consegue mostrar, de forma clara, como chegou a uma decisão. Ou seja, ela não se limita a mostrar o resultado, mas também explica o “como” e o “por que” por trás da decisão do algoritmo.

Esse conceito é conhecido como explicabilidade, que é central na XAI e se apoia em 3 pilares principais:

- Rastreabilidade (traceability): possibilidade de acompanhar o caminho da decisão, ligando claramente os dados de entrada à saída.

- Transparência da decisão (transparency): mostra como o modelo processa e “pondera” os dados para chegar a uma conclusão, e não apenas quais deles foram usados.

- Compreensão humana (interpretability): objetivo final da XAI, garantindo que a explicação seja humanamente compreensível, relevante e útil.

Leia também: IA Generativa — o que é e ferramentas

IA tradicional (caixa-preta) x IA Explicável (transparente): principais diferenças

Até aqui, vimos que os modelos de IA explicáveis se destacam por mostrar de forma clara como chegam às suas decisões. Isso os diferencia dos modelos tradicionais, chamados de “caixas-pretas”, em que sabemos quais dados entram e quais resultados saem, mas não entendemos o processo que liga os dois.

Contudo, existem outras diferenças importantes entre esses dois tipos de IA. Explicamos melhor na tabela a seguir:

| Característica | IA “caixa-preta” (tradicional) | IA explicável (XAI) |

|---|---|---|

| Foco | Prioriza chegar ao melhor resultado possível. | Quer bons resultados, mas também mostrar como chegou neles. |

| Processo | O sistema usa fórmulas e cálculos complexos, sendo opaco e difícil de auditar. | Usa recursos extras que permitem explicar, passo a passo, a lógica usada para tomar cada decisão. |

| Saída | Só mostra o resultado. Ex.: “seu crédito foi negado”. | Mostra o resultado e o motivo. Ex.: “crédito negado porque sua renda está abaixo do mínimo exigido”. |

| Velocidade de execução | Processamento rápido focado só no cálculo. | Pode levar mais tempo devido à geração das explicações. |

Como funciona a IA Explicável?

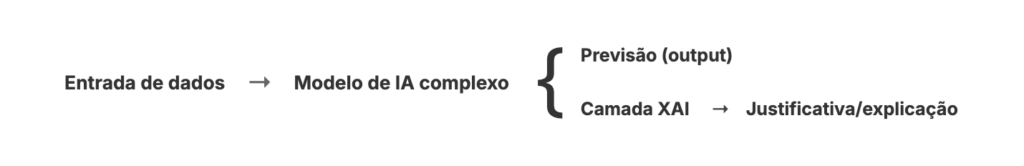

Para ser possível entender como um sistema toma suas decisões, a IA Explicável inclui uma camada que traduz e explica a lógica do algoritmo. Dessa forma, ela funciona como uma “ponte” entre a precisão dos modelos complexos e a necessidade das pessoas de compreender e confiar nos resultados.

Para facilitar a compreensão, o fluxograma abaixo mostra como a XAI funciona:

Mas como a XAI é usada na prática?

Hoje, a Inteligência Artificial Explicável está presente em diversos setores, especialmente os de alto risco ou regulamentados, pois permite que empresas e pessoas entendam, revisem e confiem nas decisões de modelos complexos de Machine Learning. Ela é usada, por exemplo, para:

- Decisão de crédito e empréstimos: em análises financeiras, a IA pode explicar por que uma solicitação foi aprovada ou recusada, destacando fatores que pesaram mais na decisão, como histórico de pagamentos, renda ou nível de endividamento.

- Cibersegurança: em sistemas de proteção digital, a XAI é capaz de apontar que um e-mail é suspeito e explicar quais sinais levaram ao alerta, como remetente forjado, links ocultos ou anexos incomuns.

- Triagem de currículos: em um processo seletivo, um sistema de IA mostra por que uma pessoa foi priorizada, indicando critérios como experiência ou habilidades consideradas no processo.

- Controle de qualidade automatizado: no contexto da indústria, a IA identifica peças com defeito e explica o que levou à reprovação, como desvios de medida ou acabamento.

Vale o lembrete de que, no Brasil, o Projeto de Lei 2.338/2023 avança na criação do Marco Legal da Inteligência Artificial, reforçando princípios como transparência, explicabilidade e segurança — elementos centrais no contexto da XAI.

Leia também: Modo IA do Google: o que é e seu impacto no SEO

Benefícios da IA Explicável

A IA Explicável oferece vantagens que podem facilitar o dia a dia das empresas e melhorar suas relações com diferentes públicos. A seguir, listamos as principais:

1. Maior transparência e ética

A transparência da XAI é fundamental para gerar confiança em empresas investidoras, parceiras e clientes, que querem entender como as decisões são tomadas, especialmente quando há impacto direto sobre as pessoas envolvidas.

Em áreas sensíveis, como Saúde, Finanças, Segurança Pública e Recursos Humanos, a clareza se torna ainda mais importante, pois entender o motivo por trás de uma decisão algorítmica ajuda a prevenir erros, vieses e injustiças.

2. Redução de riscos legais e de impactos à reputação

Outro benefício da IA Explicável é reduzir os riscos das decisões automatizadas, trazendo transparência e permitindo acompanhar o caminho das decisões para garantir que elas sejam justas, corretas e confiáveis

Em vários países, as leis garantem que as pessoas tenham o “direito à explicação” quando uma decisão automatizada impacta suas vidas, por exemplo, na recusa de um empréstimo ou de uma vaga de emprego. Com a XAI, as empresas conseguem se proteger de problemas legais e financeiros, além de manterem sua reputação.

3. Decisões humanas mais assertivas com insights claros

Por fim, a XAI ajuda a melhorar a tomada de decisão, tornando os modelos de IA mais transparentes. Assim, as organizações conseguem entender por que certas recomendações são feitas, ajustar estratégias com mais segurança e alcançar melhores resultados.

Ela também pode ser uma “ferramenta de apoio”, destacando os pontos mais importantes e fornecendo informações claras sobre os riscos e benefícios de cada caso.

Principais técnicas e métodos da XAI

Na IA Explicável, os métodos podem ser classificados em duas categorias, conforme o momento em que a explicação é gerada: modelos intrínsecos (transparentes desde a criação) e métodos pós-hoc (interpretam o modelo após o treinamento).

Modelos intrínsecos

Nesse caso, a explicabilidade já faz parte do próprio modelo, ou seja, a estrutura do algoritmo é transparente desde a criação. Ele usa matemática e lógica simples, permitindo que a pessoa compreenda como funciona apenas olhando seus parâmetros.

Alguns desses modelos são conhecidos como “caixa de vidro”, e exemplos incluem:

- Regressão Linear e Logística: as previsões são calculadas combinando de forma simples as características de entrada. Cada característica recebe um peso que mostra sua importância e influência na previsão de forma positiva ou negativa.

- Árvores de Decisão (Decision Trees): o modelo funciona como conjunto de instruções SE-ENTÃO que levam à decisão final. O caminho percorrido em cada caso específico serve como explicação do resultado.

- Sistemas Baseados em Regras (Rule-Based Systems): são modelos semelhantes às Árvores de Decisão, mas em vez de um fluxo hierárquico, o resultado consiste em uma lista de regras independentes ou sequenciais.

Métodos pós-hoc

Nesse modo, a explicação é obtida a partir de um modelo complexo de Machine Learning já treinado. Ou seja, o método pós-hoc funciona como um “observador externo”, mostrando por que o modelo tomou determinada decisão e como ele opera, tornando seus resultados mais fáceis de entender.

Conheça a seguir alguns dos principais métodos pós-hoc:

- SHAP (SHapley Additive exPlanations): calcula a importância de cada característica na previsão, garantindo que o impacto seja distribuído de forma justa. Pode explicar decisões individuais ou o comportamento geral do modelo, além de funcionar com qualquer tipo de modelo (Model-Agnostic).

- LIME (Local Interpretable Model-agnostic Explanations): cria um modelo simples que imita o comportamento do modelo complexo apenas para uma previsão específica, ajudando a entender decisões individuais. Também funciona com qualquer tipo de modelo.

- Propagação de Relevância por Camadas (Layer-wise Relevance Propagation): identifica quanto cada característica contribuiu para o resultado, enviando a relevância da saída de volta até a entrada. Funciona apenas em modelos específicos (Model-Specific). apenas em modelos específicos (Model-Specific).

Conheça outras aplicações e tendências da IA no blog da Ecto!

Considerando os pontos discutidos ao longo do texto, fica evidente que a XAI deixou de ser apenas um recurso adicional para se tornar um dos caminhos para uma IA responsável. Isso porque, ao possibilitar o uso ético e auditável da tecnologia pelas organizações, ela também contribui para a inovação ser mais transparente e confiável.

Para continuar aprofundando seu conhecimento sobre tendências, aplicações e impactos da IA, continue acompanhando o Blog da Ecto! Por aqui, você encontra diversos conteúdos sobre tecnologia, ferramentas e inteligência artificial, mostrando como essa tecnologia pode ser usada em empresas, processos e decisões.

Leia também: Maneirismos da IA e como humanizar conteúdos

Imagem de capa — Fonte: @tiko33 / Freepik (2025).